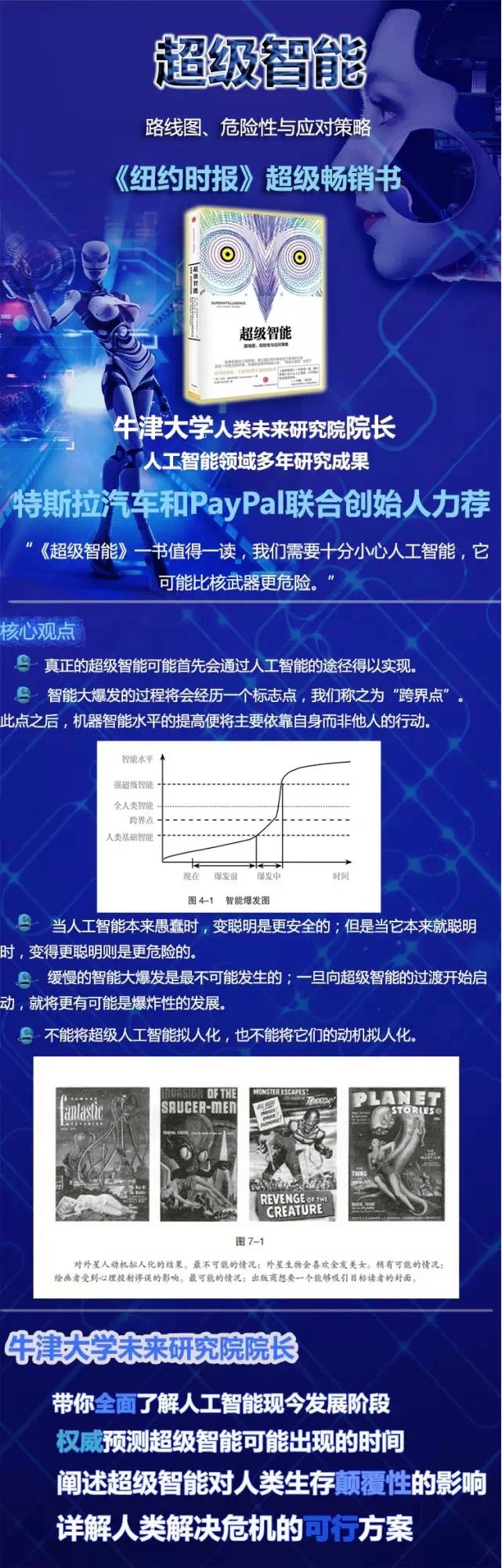

今年3月29日,微软创始人比尔•盖茨在博鳌亚洲论坛早餐会上表示,人工智能的风险并不会超过人类的智能、人类的想象,但研究开发应该特别小心,不能操之过急,注意安全性。他推荐给李彦宏一本书,就是《超级智能——路线图、危险性与应对策略》。其实,早餐会的另一位主角,特斯拉汽车和PayPal联合创始人伊隆.马斯克也是这本书的粉丝。

今年3月29日,微软创始人比尔•盖茨在博鳌亚洲论坛早餐会上表示,人工智能的风险并不会超过人类的智能、人类的想象,但研究开发应该特别小心,不能操之过急,注意安全性。他推荐给李彦宏一本书,就是《超级智能——路线图、危险性与应对策略》。其实,早餐会的另一位主角,特斯拉汽车和PayPal联合创始人伊隆.马斯克也是这本书的粉丝。

1. 何时出现超级智能?

书中对超级智能出现的可能性、时间表,超级智能的种类、特点,与人类智能的对比都做了详细的分析。对于何时出现超级智能的回答,作者给出了几种可能的时间表,但人类水平的人工智能肯定是第一步。

作者根据海量信息资料分析认为,与人类智能水平并驾齐驱的机器智能有相当大的可能在21世纪中叶实现,可能会更早,也可能会更晚;但是只要这种机器智能出现,就会很快出现超越人类智能水平的高级智能;这会对人类生存产生极其重大的影响,或是产生极好的影响,或是造成人类灭绝。不管怎样,这都说明我们很有必要去认真研究人工智能这个议题。

书中披露,最近有一项针对人工智能领域的24名研究者展开的访谈,其中一个访谈对象是尼尔斯·尼尔森,他在搜索、计划、知识表达以及机器人技术领域深耕多年,成果颇丰。他出版了许多有关人工智能的教科书,并且刚完成了一部迄今为止最通俗易懂的人工智能发展史。当被问到什么时候能够实现人类水平的人工智能时,他给出了下述观点:10%的可能是在2030年;50%的可能是在2050年;90%的可能是在2100年。

作者认为,在AI科学家的能力超越了人类科学家之后,人工智能领域的研究将由机器在数字化时间尺度内执行,进展将会相应地变得迅速。因此将存在一种智能暴涨的可能性,也就是说——我们由没有计算机比人类聪明的时代,迅速演进到机器超级智能远远胜于所有生物智能的时代。

第一个经历这种智能暴涨的AI系统将变得极为强大。它会是世界上唯一的超级智能,能够非常迅速地开发许多其他技术,比如纳米分子机器人,并利用这些技术按照其自身喜好塑造生命的未来。

2. 超级智能与人类智能相比的优劣势

虽然作者在书中长篇累牍分析机器智能与人类智能的优劣势,但我读下来发现他几乎谈的都是机器智能或者说是未来超级智能的超级优势。

在作者看来,数字大脑的优势可以从硬件和软件两个层面凸显。在硬件层面,机器智能拥有计算要素的速度优势;内部传递的光速优势;计算要素的数量优势;储存能力优势和可靠性、使用寿命、传感器等等优势,他说,成年人类大脑储存的信息低于一台手机。另外,在软件层面,机器智能有可编辑性、可复制性、目标协调性和记忆共享等优势。

作者总结道:精确拷贝一份软件是很容易的,“复制”一个人却是个缓慢的过程,而且无法将父母毕其一生获得的技能和知识直接传递给后代。编辑一个数字头脑的代码也更加容易:这使得试验及开发改进的意识结构和算法成为可能。我们能够编辑自己的脑中突触链接的细节——这就是我们所称的学习——但我们改变不了我们的神经网络运转所基于的通用原理。

因此,在《超级智能》一书较早的几个章节,作者就基本放弃了用基因改良人类或者改造人类的路线。他说,我们没有任何希望可以与这些机器脑相竞争。我们只能寄望于通过设计,让它们的目标与我们的一致。找到这么做的方法是个可畏的难题。还不清楚我们能否在某人成功造出超级智能之前解决这个难题。但是人类的命运或许有赖于以正确的顺序解决这两个问题。

由于超级智能意味着快速大脑可能主要会和其他快速大脑交流,而不是和缓慢笨拙的人类交流。作者认定需要频繁互动的极速大脑,可能会选择居住在同一栋楼的计算机里。而且在一些领域中,数量不能够替代质量。一个独居的天才可以在卧室里创作出《追忆似水年华》。而如果雇用一批文人,即使数量多得能占满整栋写字楼,他们就能创作出一样伟大的文学著作吗?甚至就在当今的人类范围内,我们也可以看到,有―些功能极大地受惠于一个绝顶聪明的头脑,而不是一大群平庸之众的集体努力。如果我们拓宽范围,把拥有超级智能的头脑包括进来,我们必须看到这种可能性:有一些智力问题只能由超级智能来解决,而在没有经过智能提升的庞大人群中,任何一个人对这些问题都无能为力。从这个角度看,作者对超级智能的出现是期待甚至欢迎的。

3. 三种形式的超级智能

作者分析可能出现3种形式的超级智能。速度超级智能、集合超级智能和能力超级智能。

速度超级智能可以做人类头脑能做到的所有事情,但要迅速得多。一个运行速度超过人脑10,000倍的智能系统能够在几秒之内阅读一本书,在一个下午完成一篇博士论文。对这样一个高速头脑来说,外部世界就像是在放慢镜头。

集合超级智能是大量人类水平的智能体组合而成的系统,这种系统的性能在整体上远胜任何目前的认知系统。以计算机软件形式运行的人类水平意识很容易被拷贝并运行在多个计算机上。如果每个拷贝的价值足以弥补硬件和电力的花销,便会发生大规模数量激增。在拥有亿万个这种智能的世界里,技术进步将比今天快许多,因为科学家和发明家的数量会是今天的成千上万倍。需要注意的是,集体超级智能的标准是以当代(即21世纪初期)的智能水平为参照的—纵观人类史前时代以及人类历史,人类的集体智能已经有了显著增长。例如,自更新世以来,世界人口已经增长了至少1000倍。如果只以更新世为基准,人类现在的集体智能水平便可被视为接近超级智能。通信技术的一些改进,特别是口头语言,也许还包括城市、文字和印刷术,分别或者共同促进了智能的巨幅提升。也就是说,如果当前人类集体解决问题的能力出现了相同级别的创新,那么就会导致产生集体超级智能。

能力超级智能,这种智能的运转速度至少和人类意识一样快,从能力上来说却要聪明得多。这是个更难理解的概念,意思是可能会出现一种智能体,它比人类聪明,正如同我们比任何其他动物聪明一样。单拿纯粹的计算力来说,人脑或许并不优于抹香鲸的脑。后者是已知最大的脑,重约7.8千克,而人脑的平均重量是1.5千克。当然,人类以外的动物的脑都完美地适合其生态需求。然而人类的脑却具备抽象思考、复杂语言表达和长期计划等能力,使我们能比其他物种更加成功地从事科学、技术和工程。但是,没有理由认为我们的脑是有可能出现的最聪明的脑。事实上我们反倒有可能是有能力创造技术文明的生物物种当中最愚蠢的。那个生态位被我们占据是因为我们首先发展到了那一步,而不是因为我们在任何意义上都最适应那个生态位。

不同类型的超级智能或许有着不同的强项和弱点。比如说,集合超级智能将善于解决易于分解为独立子问题的问题,而面对需要以新的观念性领悟或者复杂协同的思考来应对的问题,能力超级智能会具有优势。

不过不同种类超级智能的间接能力范围都是一致的。只要第一轮迭代具备了科研能力,它便很有可能迅速成长为全面综合性超级智能。那是因为,它将有能力为其自身建造当初缺失的任何认知官能所需的计算机或者认知科学研究,以及配套的开发软件。

4. 超级智能的路线图、危险性和应对策略

实际上作者后半本书,都在讨论如何限制种子超级智能的出现时间和出现条件的问题,他的观点是,第一个种子超级智能将会主宰未来的世界。为了防止这个种子超级智能对人类的威胁,他设想了各种时间表和外部条件来控制种子超级智能的孕育环境。

他认为机器智能的快速启动是危险的。计算机科学的进步会影响机器智能革命的结果,这不仅可以通过在机器智能的建造过程中发挥直接影响,而且还可以通过对于用间接方式塑造智能爆发的初始条件的社会产生弥漫性影响来实现。速度更快的计算机会使建造机器智能变得更容易。因此,加快硬件进步的一个影响就是加快机器智能的到来。

加快或推迟智能爆发的发生并不是硬件进步的速度影响存在性风险的唯一途径。另一个途径是,硬件可以在某种程度上替代软件;因此,改良的硬件就会降低编写种子人工智能代码所要求的技能下限。快速计算机还可能会导致增加对蛮力技术(比如遗传算法和其他“生成—评价—废弃”模式的方法)的依赖,同时减少对需要深入理解的技术的依赖。如果蛮力技术应用于更加无秩序的或不精确的系统设计(与精确设计和理论上受约束的系统相比,这样的系统的控制问题更难解决),那么这也是快速计算机增加存在性风险的一个方式。

另外一个考虑是,迅速的硬件进步会增加快速启动的可能性。半导体领域的发展速度越快,用于开发任何性能水平的计算机实力所需的程序员的人时(即一个人一天完成的工作量)就越少。因此,快速的硬件进步将有可能使得向超级智能的转变更加迅速,更具爆发性。

快速启动也有一些优势。它可能会增加形成单一体的可能性。如果建立单一体对于解决后过渡时期协调问题具有足够的重要性,那么为了降低后过渡时期灾难性协调问题的风险,在智能爆发阶段承受更大的风险就可能是值得的。

与机器智能在计算机硬件和软件系统上的快速启动相比,作者认为全脑仿真是一种比较可行的稳妥方案。致力于发展全脑仿真的研究可能会导致神经形态人工智能的产生,而神经形态人工智能是一种非常不安全的机器智能形式。但全脑仿真至少有三个推定的优势:1.与人工智能相比,我们对它的性能特征有更多的理解;2.它会继承人类的动机系统;3. 它会导致更慢的启动。

如果先发展人工智能,可能就会只有一次智能爆发。但是如果先发展全脑仿真,则可能会出现两次智能爆发:第一次是实现全脑仿真,第二次是实现人工智能。全脑仿真优先途径的全部存在性风险是第一次过渡和第二次过渡的风险总和。(前提是成功渡过了第一次转变)

总的来说,如果在人工智能之前建造全脑仿真,似乎人工智能过渡的风险就会降低。然而,当我们把人工智能过渡的剩余风险和先行全脑仿真过渡的风险相结合,我们就非常不确定全脑仿真优先路径的全部存在性风险与人工智能优先路径的风险相比是大还是小。只有当人们对生物学人类掌控人工智能过渡的能力非常悲观的时候(考虑到当我们真正面对这个挑战时,人类的本质或文明可能已得到改良),才会认为全脑仿真优先路径有吸引力。

全脑仿真则需要大量费力的先导步骤:高通过量的扫描设备,图像处理软件,细致的神经建模工作。因此,我们可以确定全脑仿真不会很快来临(不早于15或20年之后)。这意味着只有在机器智能的研发相对落后时,加快全脑仿真的研发才会产生不同的影响。

因此,当满足下列条件时,提倡全脑仿真便是最有吸引力的策略:1.对人类解决人工智能控制问题的能力非常悲观;2.对神经形态人工智能、多极结局或者二次过渡的风险不是特别担忧;3.认为全脑仿真和人工智能的默认实现时间是相近的;4.希望超级智能的实现既不是非常晚也不是非常早。

5. 人类如何为智能大爆发做准备?

对于如何控制超级智能,作者提出了两大路径。

一为能力控制,分为四类:盒子方法(系统受到限制,只能够通过有限制的、提前批准的渠道对外界产生影响,包括物理遏制和信息遏制两种方法);激励方法(系统被放置在提供适当激励的环境中);阻碍发展(对系统的认知能力或影响关键内部过程的能力进行限制);绊网(对系统进行诊断测试,如果探测到系统有危险行为,就将其关闭)。

二为动机选择,也分为四类:直接规定(系统装载直接规定的动机系统);驯化(设计一套动机系统,严格限制超级智能的目标和行为范围);间接规范(依靠间接手段来确定需要被遵守的规则和需要被追求的价值);扩增(选择一个已经具有类似人类的、友好的动机系统,对其认知能力进行提升,使其成为超级智能)。在超级智能出现之前,人类需要做好应对准备,而当超级智能出现,人类应该可以找到控制办法。

虽然作者提出了超级智能对人类的种种威胁,但由于对超级智能相对于人类智能的优势的憧憬,他在书的后半部分,甚至没怎么提及人类在超级智能统治的世界中该如何自处。而是将所有的焦点都集中于对种子超级智能的培育和筛选上面。也就是说,他认为人类目前扮演的上帝角色,而第一个出现的种子超级智能就相当于未来世界的亚当和夏娃。

鉴于超级智能对未来世界的强大统治能力,也就不难理解美国对中国的超级计算机发展实施各种遏制手段或其他战略举措。可以说谁掌握了种子超级智能的设计权和制造权,谁就掌握了打开未来世界大门的超级钥匙。

作者最后的总结可以看得出纠结。他说出于同样的原因,人类影响视角支持很多危险的技术创新。这些技术创新可能会加速智能爆发的启动,而非人类视角是不赞成这些创新的,因为这些创新会缩短我们紧紧抓住生命的树枝直到迎来后人类时期的曙光的时间。因此,从人类影响视角来看,快速的硬件进步似乎是有益的,就像加快研发全脑仿真一样。而与目前活着的人能够有更大的机会在其有生之年享受智能爆发带来的个人利益相比,任何对存在性风险的不利影响大概就没那么重要了。

总结而言,无论人类愿不愿意,是否准备充分,智能大爆发都有可能到来。尼克·波斯特洛姆的《超级智能》影响了西方思想界和企业界。期待中国也有类似的研究机构、学者,从中国的角度对超级智能做进一步深入的研究和探讨。

上一篇:�没有了 下一篇:22个国外电子书免费下载网站 |

尚特微信

内容编辑

内容编辑